Hoje, trazemos uma importante notícia vinda diretamente de Boston. O uso crescente de modelos de linguagem, como o ChatGPT, tem se disseminado rapidamente em diversos setores. Entretanto, duas autoridades médicas da Food and Drug Administration (FDA) e da European Medicines Agency (EMA) declararam ontem que não cogitam para breve utilizar essa nova tecnologia para acelerar as análises de medicamentos.

Durante a conferência anual da Drug Information Association (DIA), na quinta-feira (29/6), o diretor de marketing da EMA, Steffen Thirstrup, destacou uma preocupação crucial: “Garbage in, garbage out” [o que entra, sai], referindo-se ao fato de que esses modelos captam apenas o que já foi publicado, representando apenas a ponta do iceberg.

Basear o conhecimento das equipes de revisão apenas nessa ponta de iceberg, sem levar em conta todos os programas em desenvolvimento que foram descartados pela indústria por diversas razões, pode ser perigoso, alertou Thirstrup.

No entanto, ele enfatizou que esse é um tema que precisa ser mais discutido no futuro, especialmente à medida que cada vez mais empresas recorrem à inteligência artificial e à aprendizagem de máquina em seus esforços de desenvolvimento.

Sentada ao lado de Thirstrup, a diretora de marketing da FDA, Hilary Marston, concordou que os modelos de linguagem são parte de um campo em rápido movimento, mas ressaltou que é difícil compreender como o ChatGPT chega a algumas conclusões e que ele, ocasionalmente, pode inventar informações, o que pode ser prejudicial.

Marston também revelou que mantém um diálogo regular com seu homólogo na EMA, abordando diversos temas de saúde pública, incluindo recentemente o shortage (falta) de medicamentos, a xilazina e a geração de evidências.

Ela também comentou sobre o crescente desafio do desabastecimento de medicamentos (shortage) nos Estados Unidos, principalmente porque as margens de lucro para as empresas farmacêuticas de genéricos são muito estreitas.

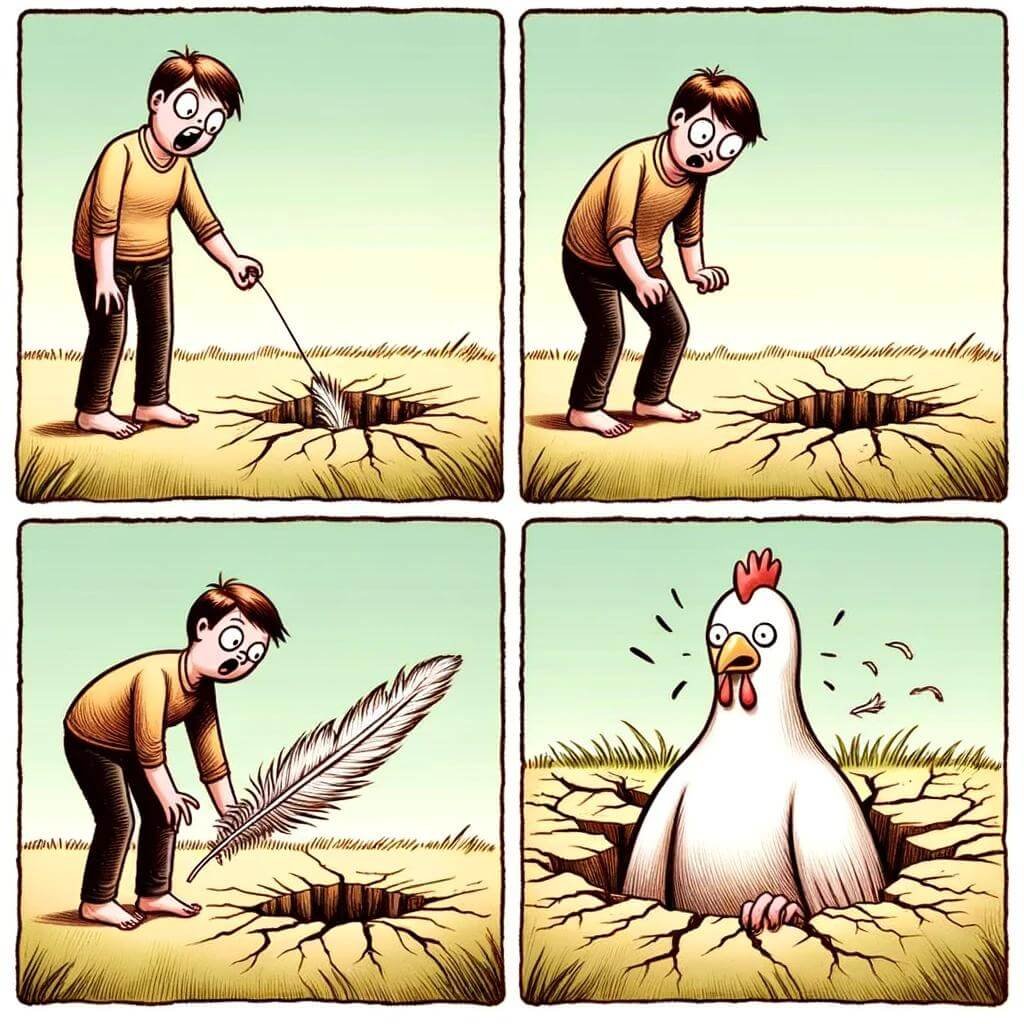

“O que temos visto em nossos dados é que o número de shortages reais em nível nacional se estabilizou, mas o número de shortages mitigadas continua aumentando. E a razão para isso é que estamos jogando ‘whack-a-mole’ (um jogo de acertar o topo do mole com um martelo)”, disse Marston. “Regulamentações por si só não resolverão esse problema.”

Essa discussão sobre o uso de modelos de linguagem para agilizar análises de medicamentos certamente continuará ganhando espaço nos debates futuros. A tecnologia avança a passos largos, mas é importante refletir sobre suas limitações e riscos, garantindo a segurança e a eficácia nos processos regulatórios farmacêuticos.

Whack-a-mole

“Uma situação em que os problemas vão surgindo continuamente e aleatoriamente (assim que você resolve um problema, outro aparece e assim por diante) e todos os esforços para corrigi-los estão produzindo apenas resultados incompletos ou temporários”

O que é o ChatGPT?

O ChatGPT é um modelo de linguagem baseado em inteligência artificial (IA) chamado “GPT-3.5”, desenvolvido pela OpenAI. Ele foi treinado em uma enorme quantidade de dados textuais para entender e gerar texto em linguagem natural.

O modelo é construído em uma arquitetura de rede neural chamada Transformer, que permite que ele processe informações e gere respostas com base em sequências de palavras. Ele aprende a reconhecer padrões e estruturas gramaticais nos textos com os quais foi treinado.

Para treinar o ChatGPT, ele foi alimentado com bilhões de palavras de diferentes fontes, como livros, artigos da internet e até conversas humanas. Isso permite que o modelo tenha um amplo conhecimento de diversos assuntos, desde ciência e história até esportes e cultura.

Quando você faz uma pergunta ao ChatGPT, ele analisa o texto da sua pergunta, identifica as palavras-chave e padrões de linguagem e, em seguida, gera uma resposta com base no contexto fornecido. Ele tenta fornecer a resposta mais relevante e coerente possível, com base em sua experiência prévia.

É importante ressaltar que, embora o ChatGPT seja capaz de produzir respostas impressionantes, ele também pode cometer erros e não tem a capacidade de compreender o mundo da mesma forma que os humanos. Portanto, é sempre necessário verificar as informações obtidas com outras fontes confiáveis.

Riscos envolvidos

O blog Academia de Pacientes ouviu Márcio Galvão, engenheiro de produção e voluntário da Associação Brasileira de Ataxias Hereditárias e Adquiridas (Abahe).

Eis sua opinião sobre o tema:

Sobre o uso de Large Language Models (LLM), como o ChatGPT, nos produtos que são regulados pela FDA, como no desenvolvimento de novos medicamentos, seria importante ter em mente que não existe ainda um marco regulatório adequado para a inteligência artificial (IA) em nenhum lugar do mundo (embora esteja em desenvolvimento na Europa, no Brasil e em várias outras partes do mundo).

A FDA terá ela própria autoridade para regulamentar o uso do ChatGPT e similares no âmbito em que atua? Há o risco de imprecisão nas respostas. A FDA vai se ocupar do modelo “padrão” do ChatGPT, treinado com dados da Internet incluindo fontes pouco confiáveis, ou estamos falando de modelos customizados, treinados com dados de fontes selecionadas por curadores e com seus parâmetros ajustados para maior precisão de respostas em domínios específicos?

Finalmente os LLMs não são estáticos, eles evoluem. Talvez com o tempo possa surgir um viés mais robusto no modelo (preconceito de algoritmo) que afete sua imparcialidade.

Como esta evolução será monitorada pela FDA, uma vez que o uso dos LLMs tenha sido autorizado para esta ou aquela finalidade?

Fique ligado em nosso blog para mais atualizações sobre esse e outros assuntos relevantes! Até a próxima!

[USM_form]